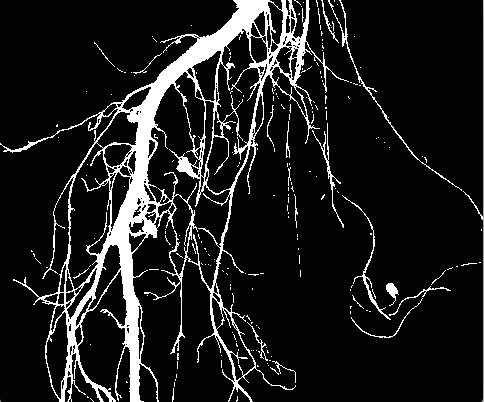

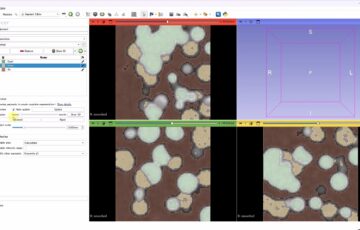

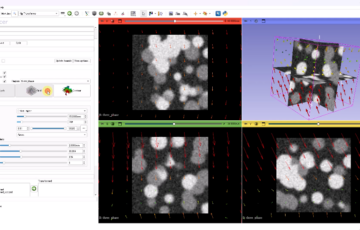

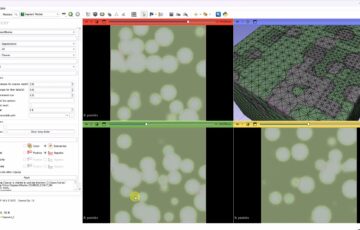

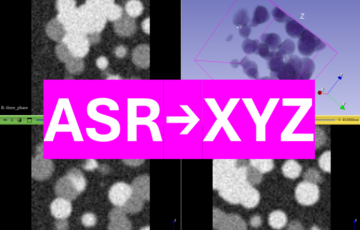

空撮動画の解析の流れを示しています。ドローンなどを使って真上から高度一定で撮影するという条件のもとで、カメラの座標推定から高精度なパノラママップの作成までのチュートリアルです。難易度は高めです。

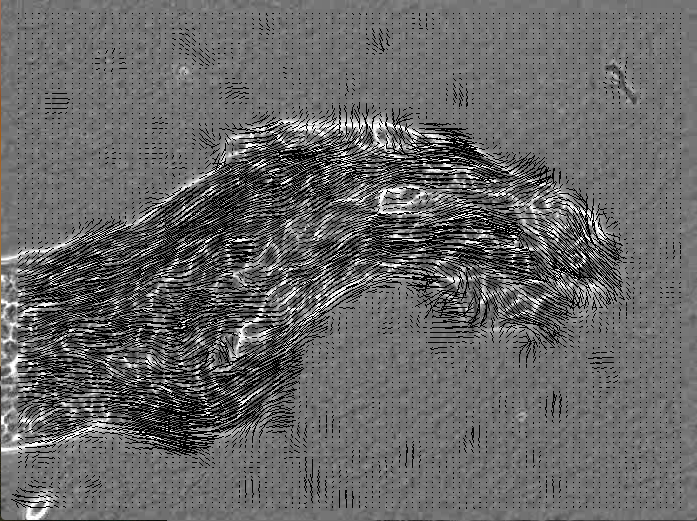

最近のGPSの性能は上がってきていますが、数cm以下の誤差で抑えられるようなGPS受信機は手頃な価格では手に入りません。そこで、上空から真下に向けて撮影した動画を元にカメラの移動を計算する方法を解説します。下のサンプル動画は、右クリックからダウンロードすることができます。

なお、空撮に関しては、高価なマルチコプター(複数の羽をもつヘリコプター)を使用するほど大きなカメラを搭載可能で、高画質の映像を得られる傾向があります。ですが、安価なマルチコプターでも空撮が可能な機種はありますので、それを利用するのも良いと思います。DJIのドローンはとても安定しているのでおすすめです。ただし、このような小型のドローンを飛ばすために、免許などは不要なものの、飛行が制限されている場所もあるので注意が必要です。詳細なルールは国土交通省のホームページや、ユーザー登録が必要となりますが、ドローン専用飛行支援地図サービスなどを参照してください。